llamafile+贝锐花生壳教程:本地部署 AI 模型,内网穿透实现远程访问

- 游戏资讯

- 2025-08-08

- 3

通常来说本地运行大模型相对比较麻烦,需要部署各类环境。不过,目前 Mozilla 推出了一个轻量化本地大模型推理工具 llamafile。它将模型参数、推理代码和运行环境全部打包为一个可执行文件,支持 Windows、macOS 和 Linux 平台,真正实现「一键启动大模型」。

有了 llamafile 你无需安装 Python 环境、无需依赖复杂的库,仅下载一个文件,就能在本地运行 LLaMA、Mistral 等开源大模型,非常适合开发者测试、离线使用或私有部署。

接下来,将带大家使用 llamafile,并通过贝锐花生壳内网穿透实现远程访问,无需公网 IP,出门在外也能远程访问家电脑运行的本地 AI 服务!

一、llamafile本地快速运行教程(以Windows为例)

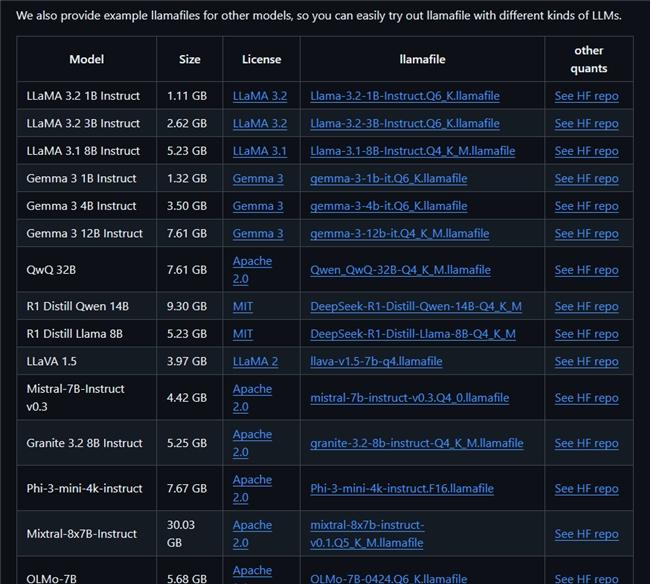

前往 llamafile GitHub 主页,可直接下载已经整合好的模型文件,目前主页下方直接列出了已有的模型和下载入口,按需下载至本地即可。

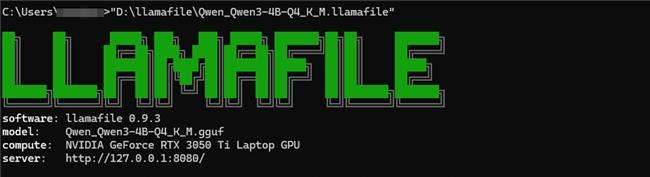

打开电脑的终端,如果使用的是 macOS、Linux 系统,需要先授予该文件执行权限(只需操作一次,以 Qwen_Qwen3-4B-Q4_K_M.llamafile 为例)。

如果使用的是 Windows 系统,可将该文件重命名,在文件名末尾添加.exe 后缀。然后,直接输入「路径+文件名」就能运行 llamafile。

运行上述命令后,在浏览器中访问 localhost:8080,就能和大模型开始对话。

二、使用贝锐花生壳实现内网穿透,让异地也能远程访问llamafile

如果你希望在手机、其他电脑上访问这个大模型服务,或者部署在 NAS 上供多用户使用,会遇到一个现实问题:家用宽带没有公网 IP,或者没有光猫端口转发的配置权限,导致外网无法访问 localhost:8080 的 llamafile 服务。

这时,我们可以借助贝锐花生壳内网穿透,快速将本地 llamafile 服务映射到公网,让任何设备都能访问。

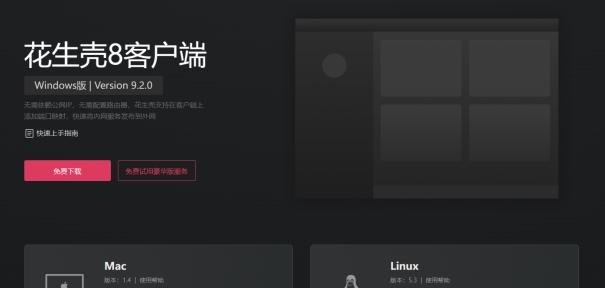

1. 前往贝锐官网下载贝锐花生壳客户端(支持 Windows、Linux、MacOS、Docker 以及各类 NAS),在 llamafile 服务器上安装并登录账号。

2. 在客户端中添加「HTTPS 映射」,内网主机地址填写本机局域网 IP,内网端口 8080。

3. 保存后即可获得一个域名形式的远程访问地址用手机、远程电脑输入该地址,就能随时随地访问 llamafile。

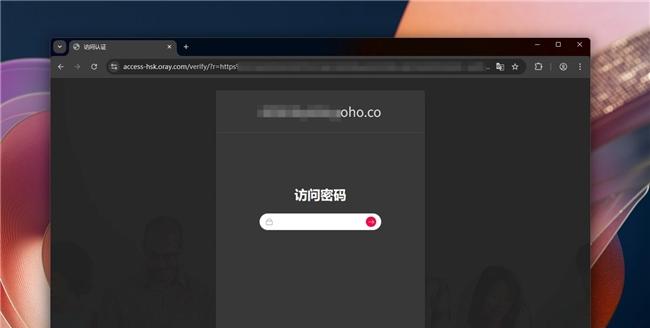

由于 llamafile 默认不要任何身份验证就能使用,为了防止恶意访问,可使用贝锐花生壳内网穿透的安全功能加强防护。

贝锐花生壳支持大量安全功能,如:Web 访问口令验证,限制外部访问必须输入密码;访问来源限制,仅允许指定 IP、设备、浏览器连接。同时,贝锐花生壳还有爆破防护功能,能够自动识别并拦截那些可能对映射服务构成威胁的高频访问请求。

总体来说,通过将 llamafile 本地部署与贝锐花生壳的公网访问能力相结合,我们可以轻松打造一个灵活、安全的大模型应用环境。无需复杂依赖,仅需一个可执行文件,即可实现本地大模型的快速启动。同时,即便是在没有公网 IP 的网络环境中,也能通过花生壳实现远程访问,突破传统部署的网络限制。

来源:互联网

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。!

本文链接:https://www.huorao.com/article-13313-1.html